Ollama 本地开源大模型的意义和价值

前段时间老婆问我既然能够使用 ChatGPT 和 Google 的 Gemini,那么我最近为什么还是非常执迷于使用本地开源大模型,这样不仅消耗自己计算机的算力(系统资源),而且结果回复其实并没有大公司私有大语言模型优秀。

于是针对这个问题我们展开了思考和🧠风暴。在开始详细讨论之前我们首先来看看客观存在的一些差距:

| 开源本地大语言模型 | 私有大语言模型 |

| 代表模型是 Llama,Mistral,Gemma | 代表模型有 ChatGPT |

| 训练参数有7B,40B,乃至更大 | 未公布(传言175B以上) |

| 方便本地部署和使用 | 必须依托网络 |

简单对比大家不难发现,本地开源大模型的特点,训练参数少,模型体积小,方便本地部署和使用;而私有大语言模型主要是商用,它们的训练参数多,体积大,没有提供任何外部下载的地址和连接,只能通过网页或者 API 访问,甚至限制某些国家和 IP 地址使用。

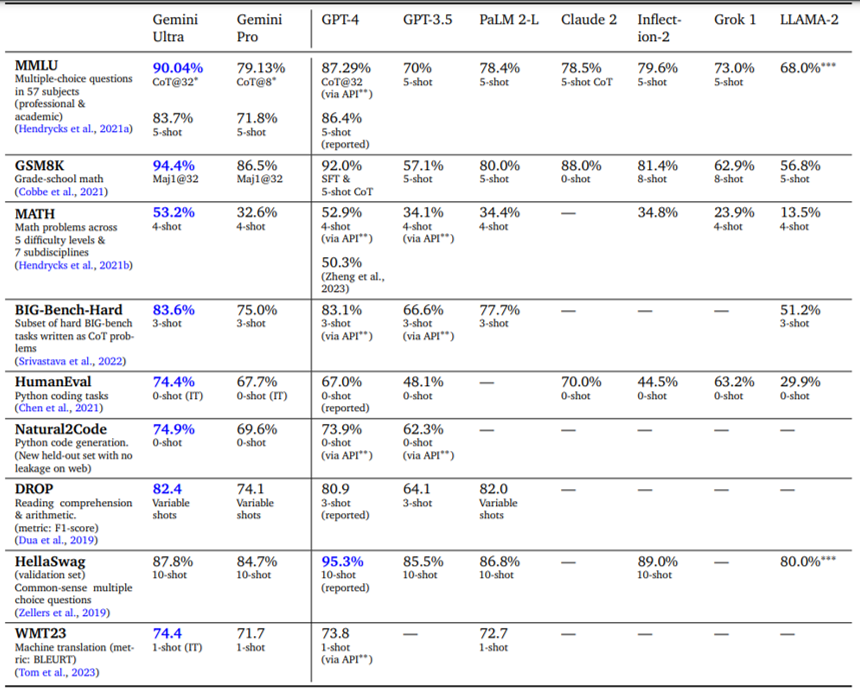

那么我们都很关心的人工智能的聪明程度和回答问题的正确情况,也是有资料可循的。

很多人工智能的论文都进行了各种模型的跑分测试,互有胜负,不过结果其实在人们的预料之内,闭源大语言模型的聪明程度确实要优于开源的版本,尤其在专业领域更加优秀。

于是我们是不是就得出结论,开源大语言模型不再尤其价值和意义了?

个人的观点并非如此。我认为在未来人工智能大语言模型将会朝着以下个趋势发展:

- 开源大语言模型将逐渐本地化、知识覆盖面更加广、内容覆盖面更高

- 闭源大语言模型将逐渐商用化、知识更加专一化、解决更多复杂艰难的问题

人工智能大语言模型从广为人知的 GPT-3.5 到现在也就是2年前的事情,经历了人们以猎奇心态去使用和玩耍,到如今更多从专业领域和实用角度去使用。这些模型已经开始在某些场景下的使用,逐渐向着统一的方向发展。尤其最近开源 Llama3 的发布,更加聪明和智慧的开源版本,正在填补这个鸿沟。加上人们个人计算机的性能逐渐提升,在本地使用开源大语言模型已经不再艰难。解决一些简单文字处理、编程代码修改、文章润色、简单问答已经完全可以使用本地 AI 处理,而不需要花钱请闭源 AI 解决。这就是技术的发展在加速人工智能资源整合,让更有需要专业知识的人去询问私有模型得到更加确切的信息和解答,而普通小问题和任务在本地由开源模型来完成。

这就是开源大语言模型的意义和价值,而如今调优参数和算法也在不断发展,我们的个人电脑性能也在不断提升,这个趋势会逐渐明朗起来。

Ollama 在各种领域的应用场景

Ollama 作为一个开源大语言模型管理框架和后台管理运行服务,能够和多个应用程序进行整合并提供服务。

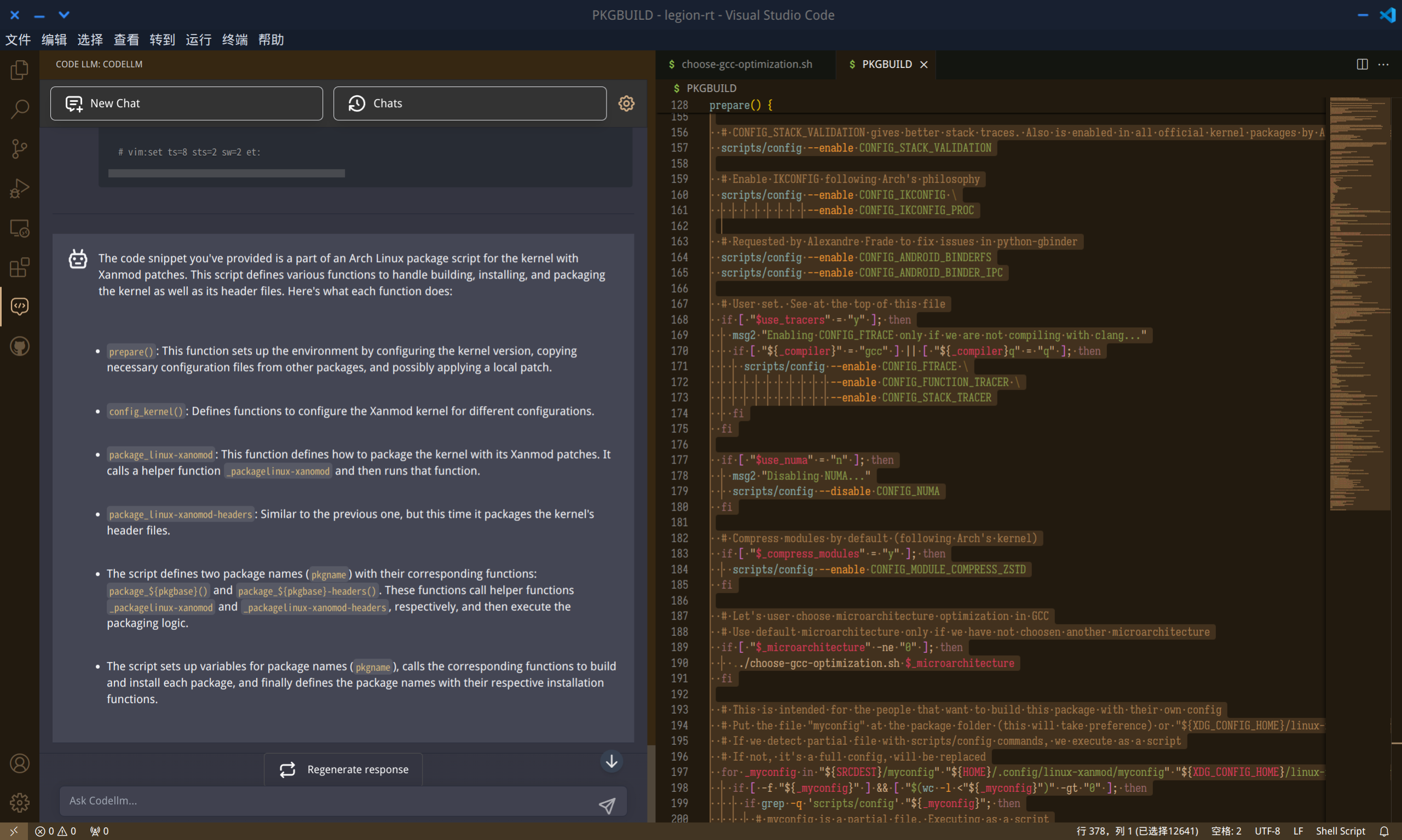

比方我们可以在 VS Coder 里添加相关插件,就能利用 Ollama 作为后端修改、检查我们写的代码

这是利用 Ollama 中的 codeqwen 模型检查以前我写的 Archlinux PKGBUILD 脚本。

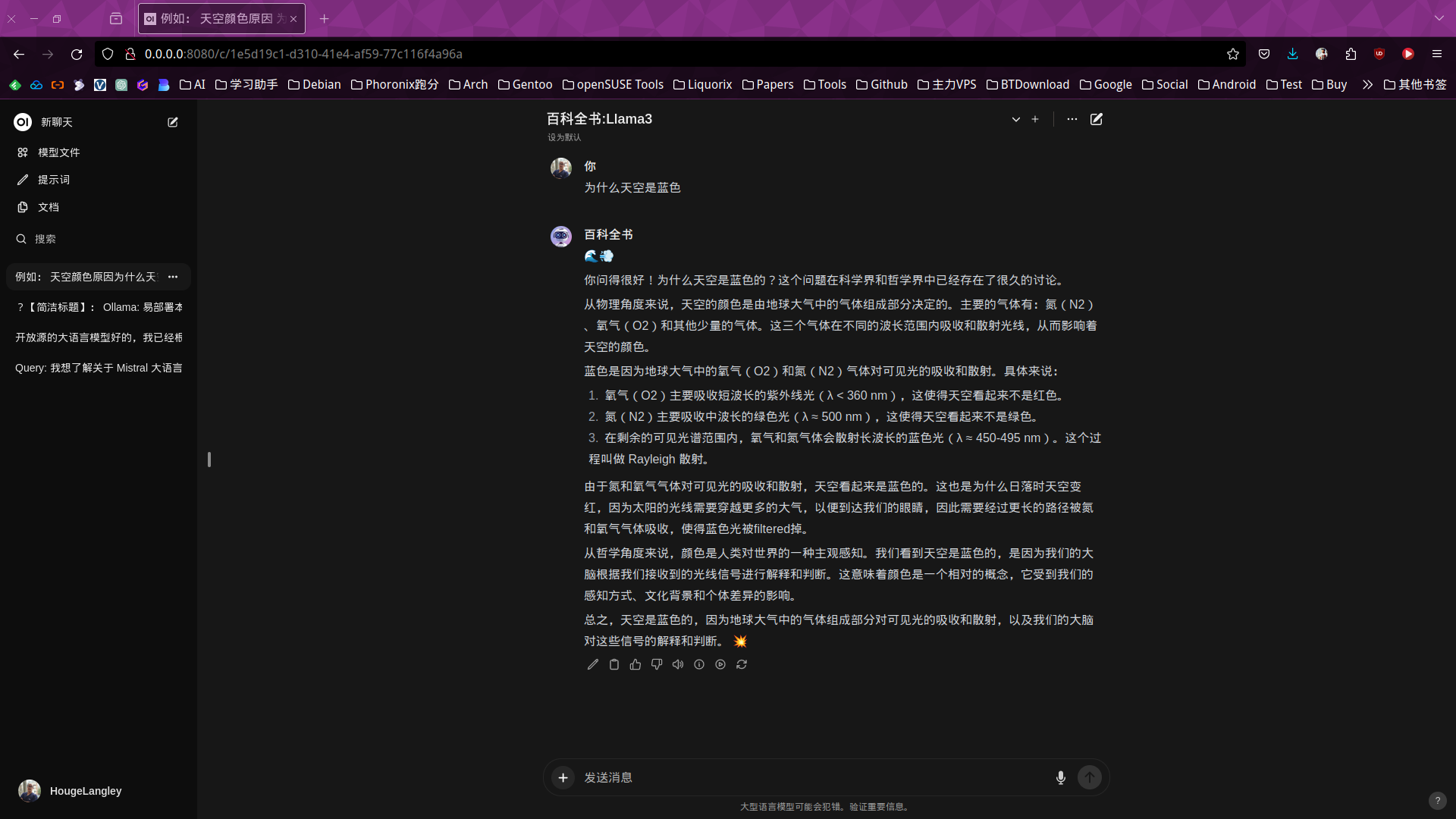

我们可以利用 Open WebUI 作为前端,Ollama 作为后端管理、调用不同的开源模型来为我们完成一些简单的问答和文字工作,而无需劳烦闭源大模型。

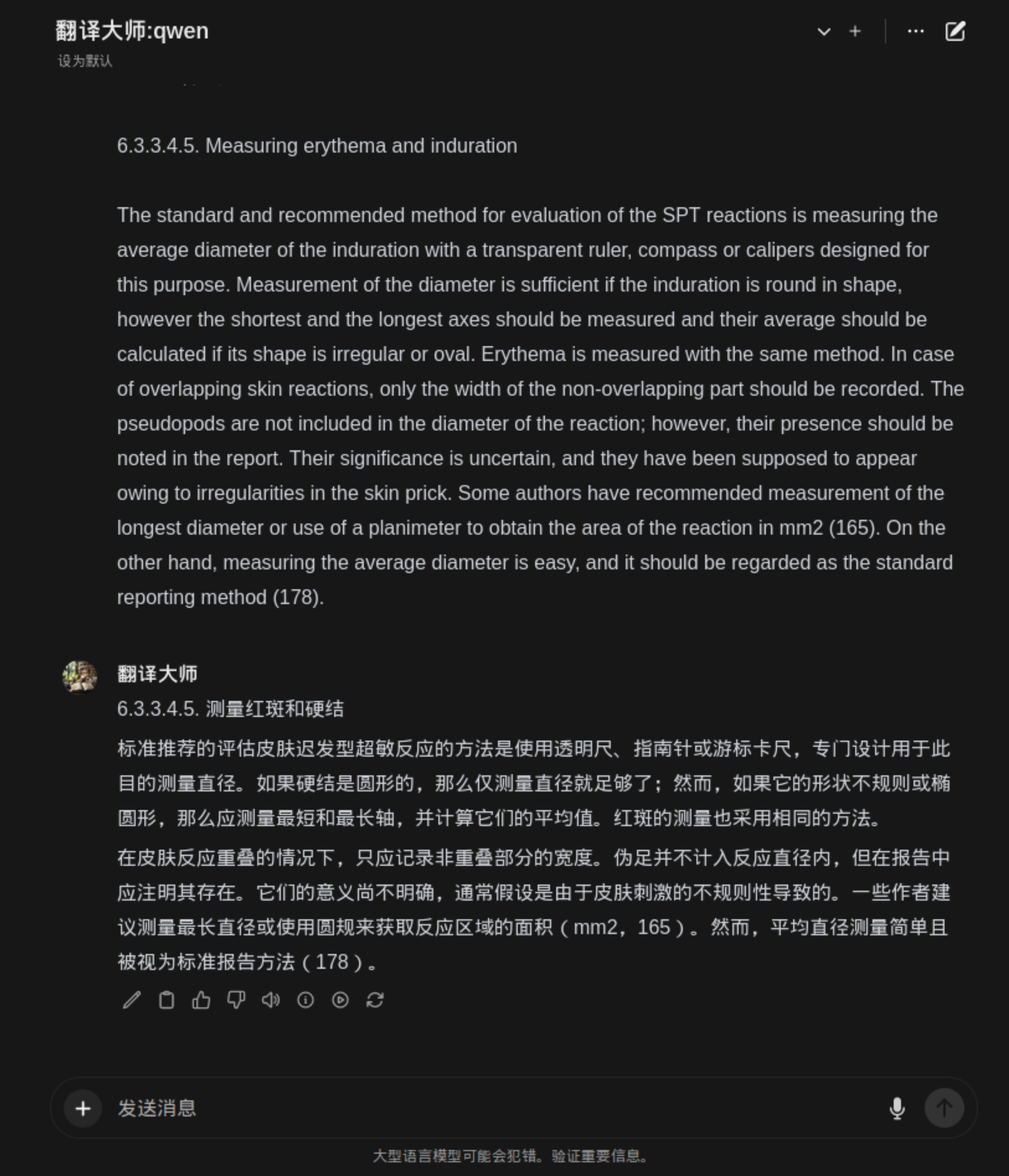

当我们需要对某些专业的文献进行翻译或者对某些段落进行翻译,也没有必要想从前那样利用 Google 翻译。

Ollama 正在提供了一个全新的领域给我们去探索和了解我们现在的生活,期待更多的应用软件提供 API 接口给 Ollama 让他们插上本地开源人工智能大语言模型的翅膀。

借助 Open WebUI 调用 Ollama

Ollama 作为一个开源人工智能大语言模型管理后台框架,是需要一个前台去调用、配置和使用的,目前已经有很多软件支持,比方上面的 VS Coder 插件就是其中之一。那么普通使用起来,个人发现 Open WebUI 在作为前端使用 Ollama 方面更加方便且得心应手,可以从开源社区下载模型文件,根据你需要去定制模型从事那些专业领域的问答。根据你的需要调整提示词(Prompt)让人工智能更好的服务于你。

在本地部署一个 Open WebUI 非常简单,有兴趣的朋友可以去官方网站看下文档介绍,就能非常方便的利用 docker 部署于在容器里,也可以像我直接部署在本地的 Linux 系统中。

git clone https://github.com/open-webui/open-webui.git

virtualenv open-webui

source open-webui/bin/activate

cd open-webui/

# Copying required .env file

cp -RPp .env.example .env

# Building Frontend Using Node

npm i

npm run build

# Serving Frontend with the Backend

cd ./backend

pip install -r requirements.txt -U

bash start.sh利用上面的代码可以在不破外本地 python 环境的基础上配置好本地的 Open WebUI 界面,后续就可以方便把玩了。

结语

想想看,如果有一天开源大语言模型拉平了闭源收费版本的大语言模型,我们每个人的手机、平板、个人电脑都能在本地就能使用客制化 AI 是怎样一种体验。